딥러닝 기술을 이용해 이미지를 이해하는 연구는 여러 회사에서 경쟁적으로 추진하고 있다. 페이스북의 딥페이스가 인간 수준으로 얼굴을 인식할 수 있음으로 보여주었고, 지도 학습이 아닌 자율학습으로 이미지 안의 특정한 객체를 인식해 내는 것은 구글과 마이크로소프트에서 연구 결과로 발표한 적이 있다.

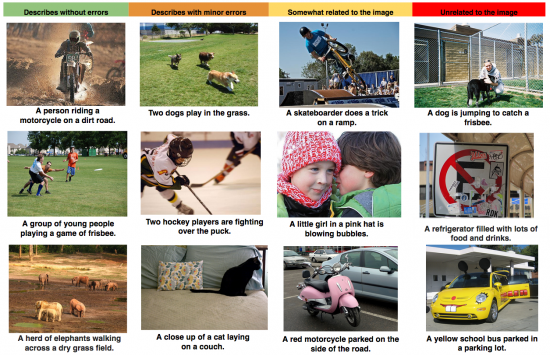

이번에 구글에서 발표한 논문의 내용은 컴퓨터 비전과 자동 번역 기술을 활용해 이미지 안의 어떤 객체들이 있는 가를 인식하고 이를 자연스러운 문장으로 기술하는 방식을 선보였다. 구글 블로그에 의하면 이미지 인식에는 컨볼루션 뉴럴 네트워크(CNN)를 이를 언어로 기술하는 데는 리커런트 뉴럴 네트워크 (RNN)를 조합해서 구성했다고 한다.

테크크런치에 따르면 결과의 정확도는 아직 인간에 비해 모자라는데, 자동 번역에 사용하는 평가 알고리듬인 BLEU를 기준으로 하면 이번 연구는 데이터에 따라 27점에서 59점 수준인데, 인간은 보통 69점 수준이라고 한다.

이러한 기술은 인공지능 기기에서 사용할 수 있을 뿐만 아니라 시각 장애인들에게 친절하게 현재 보고 있는 이미지의 내용이 무엇인지 쉽게 설명해 줄 수 있을 것이다. 완성된 문장을 다시 음성으로 바꾸기만 하면 된다.

[추가 자료]

![CNN과 RNN을 결합한 모델 [출처: 구글 블로그]](http://www.techfrontier.kr/wp-content/uploads/2014/11/image01-550x223.png)